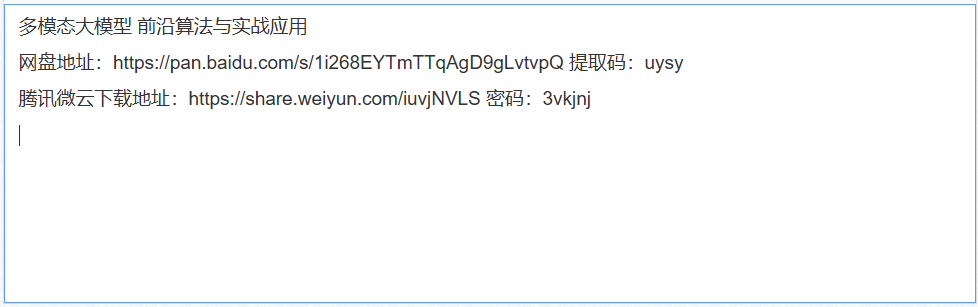

多模态大模型 前沿算法与实战应用【附源码+课件】

什么是多模态 Multimodality

多模态(Multimodality)是指集成和处理两种或两种以上不同类型的信息或数据的方法和技术。在机器学习和人工智能领域,多模态涉及的数据类型通常包括但不限于文本、图像、视频、音频和传感器数据。多模态系统的目的是利用来自多种模态的信息来提高任务的性能,提供更丰富的用户体验,或者获得更全面的数据分析结果。

多模态大型语言模型(Multimodal Large Language Models,简称MLLMs)是一类结合了大型语言模型(Large Language Models,简称LLMs)的自然语言处理能力与对其他模态(如视觉、音频等)数据的理解与生成能力的模型。这些模型通过整合文本、图像、声音等多种类型的输入和输出,提供更加丰富和自然的交互体验。

MLLMs的核心优势在于它们能够处理和理解来自不同模态的信息,并将这些信息融合以完成复杂的任务。例如,MLLMs可以分析一张图片并生成描述性的文本,或者根据文本描述生成相应的图像。这种跨模态的理解和生成能力,使得MLLMs在多个领域,如自动驾驶、智能助理、内容推荐系统、教育和培训等,都有广泛的应用前景

Modality Generator 模态生成器

模态生成器(Modality Generator, MG)是多模态学习系统中的一个关键组件,它的主要作用是生成不同模态的输出,例如图像、视频或音频。

模态生成器的具体实现可能包括但不限于以下几种技术或模型:

* 图像生成:如 Stable Diffusion,这是一种基于扩散模型的图像生成技术;

* 视频生成:如 Zeroscope,专注于视频内容的生成;

* 音频生成:如 AudioLDM,用于生成音频信号。

在多模态大模型中,模态生成器是实现模态转换和内容生成的关键技术,它使得模型能够灵活地处理和生成多种类型的数据,为用户提供更加丰富和自然的交互体验。

MMLM 的训练策略和训练数据

在多模态大型语言模型(MLLMs)的开发过程中,训练策略和数据处理方法对于模型的性能提升至关重要。通常,训练分为三个主要阶段:预训练,指令微调和对齐微调。

1. 预训练

预训练的主要目标是对齐不同模态,同时让模型学习多模态世界中的丰富知识。这个阶段通常需要大规模的文本配对数据(如图像-文本对、音频-文本对),这些数据能够为模型提供广泛的上下文和世界知识。在预训练过程中,常见的输入格式是将一段描述性文本与对应的图像、音频或视频配对,通过交叉熵损失函数进行训练。这种方式确保了模型能够在不同模态之间建立有效的关联。

预训练的方法通常有两种:一种是冻结 LLMs 和视觉编码器,只训练模态接口,这样可以保留模型已有的预训练知识,代表性的模型有 LLaVA、LLaVA-med 和 Detgpt;另一种是开放视觉编码器的参数,在对齐过程中有更多的参数可以进行微调训练,这类方法通常在需要更精确对齐的任务中使用,代表性模型有 Qwen-VL、mPLUG-Owl 和 VisionLLM。

2. 指令微调(Instruction-tuning)

指令微调是训练 MLLMs 的另一关键阶段,其目的是让模型更好地理解和执行用户的指令。在这一阶段,模型通过学习如何泛化到未见过的任务,从而提升零样本的性能。与传统的监督微调相比,指令微调更加灵活,能够通过适应多任务提示来提高模型的广泛应用能力。这种训练策略在自然语言处理领域已经取得了成功,推动了如 ChatGPT、InstructGPT 等模型的发展。

3. 对齐微调

为了提高多模态大型语言模型(MLLMs)在特定场景下的表现,对齐微调(Alignment Tuning)是一项不可忽视的关键步骤。对齐微调的目标是减少模型在生成过程中可能出现的“幻觉”现象,确保生成内容与输入信息保持一致。

- 请尽量让自己的回复能够对别人有帮助

- 支持 Markdown 格式, **粗体**、~~删除线~~、

`单行代码` - 支持 @ 本站用户;支持表情(输入 : 提示),见 Emoji cheat sheet

- 图片支持拖拽、截图粘贴等方式上传